财联社资讯获悉,英伟达的A100和H100 AI GPU订单增加,A800和H800的售价上涨40%,新订单交期可能延长到12月份。

一、A100和H100 AI GPU订单增加将提升光模块需求

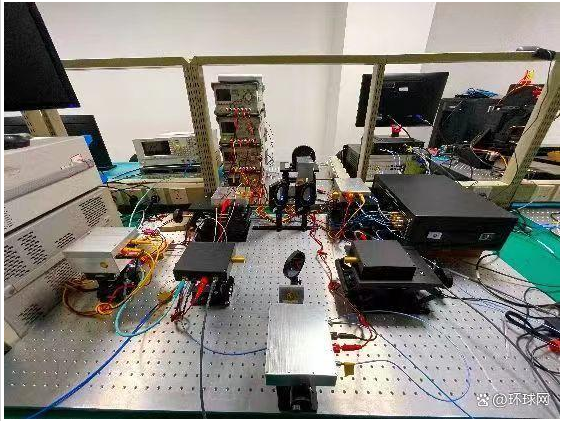

在英伟达DGXA100 SuperPOD的AI数据中心系统中,三层交换机全部为Nvidia Quantum QM8790的40端口交换机。

第一层交换机与1120张Mellanox HDR200G Infiniband网卡连接;第二层交换机下传端口与第一层相连,上传端口与第三层互联;第三层交换机只有下传端口,与第二层相连。

此外,存储侧独立组网,与计算侧网络架构分开,也需要一定数量的交换机和光模块。因此,相比较传统数据中心,AI数据中心中的交换机及光模块数量大幅提升。

英伟达的A100 GPU主要对应200G光模块,H100GPU可以对应400G或800G光模块。每个A100GPU配一张Mellanox HDR200Gb/sInfiniband网卡,每个H100GPU配一张Mellanox NDR400Gb/sInfiniband网卡。

英伟达在H100 SuperPOD的设计中,采用了800G的光模块,在光口采用1个800G光模块可以替代2个400G光模块,在电口也可以将8个SerDes通道进行整合,与光口的8个100G通道一一对应。因此这种设计下,交换机的通道密度提高,物理尺寸显著降低。

二、机构称光模块设备领域处于价值洼地

光模块速率由网卡决定,网卡的速率受限于PCIe通道速率。英伟达A100的DGX服务器内部通过NVLink3连接,单向带宽为300GB/s,但是A100 GPU连接ConnectX-6网卡是通过16个PCIe4.0通道,带宽总和为200G左右,因此网卡带宽为200G,需要连接200G的光模块或者DAC电缆。

H100的DGX服务器内部通过NVLink4连接,单向带宽为450GB/s,但是H100GPU连接ConnectX-7网卡是通过16个PCIe5.0通道,带宽总和为400G左右,因此单个网卡带宽为400G。

光模块速率是由于网卡与GPU之间的PCIe带宽所决定。假设A100和H100的DGX服务器内部所用PCIe通道速率达到800G(即PCIe6.0),那么也可以采用800G带宽的网卡,即也可以采用800G光模块,大大提升系统计算效率。

浙商证券大制造团队称,800G光模块需求预期强烈,光模块设备领域处于价值洼地。

来源:摘自财联社

未经允许不得转载:财富在线 » 800G光模块需求大增,机构称设备领域目前处于价值洼地